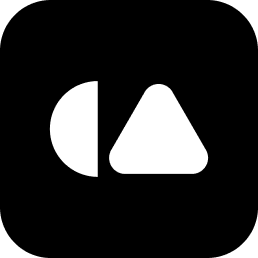

1. OpenAI GPT-5.3-Codex: "코딩을 잘하는 게 아니라, 일을 할 줄 압니다"

Open AI의 Codex는 코드를 대신 제작해주는 일명 바이브코딩을 위한 모델입니다. 그동안 Codex는 코드 짜주는 도구 정도로만 생각을 해왔죠. 그러나 이번 5.3 버전은 결이 완전히 다릅니다.

이제는 코드를 짜는 건 기본이고, 터미널 실행부터 배포, 테스트 반복까지 스스로 굴리는 에이전틱 코딩을 선보였습니다. 심지어 Codex 자신을 만들 때 스스로를 디버깅하고 평가하는 과정에 직접 투입됐다고 합니다.

👉 인사이트

AI를 활용한 코드 제작이 쉬워지는 만큼 채용의 기준이 바뀌어야 할지도 모릅니다. 코드를 한 줄 더 잘 짜는 사람보다, AI에게 업무를 어떻게 쪼개서 시키고(지시), 결과물의 리스크를 어떻게 통제할지(검증)를 아는 '디렉팅 능력'이 훨씬 중요해질 거예요.

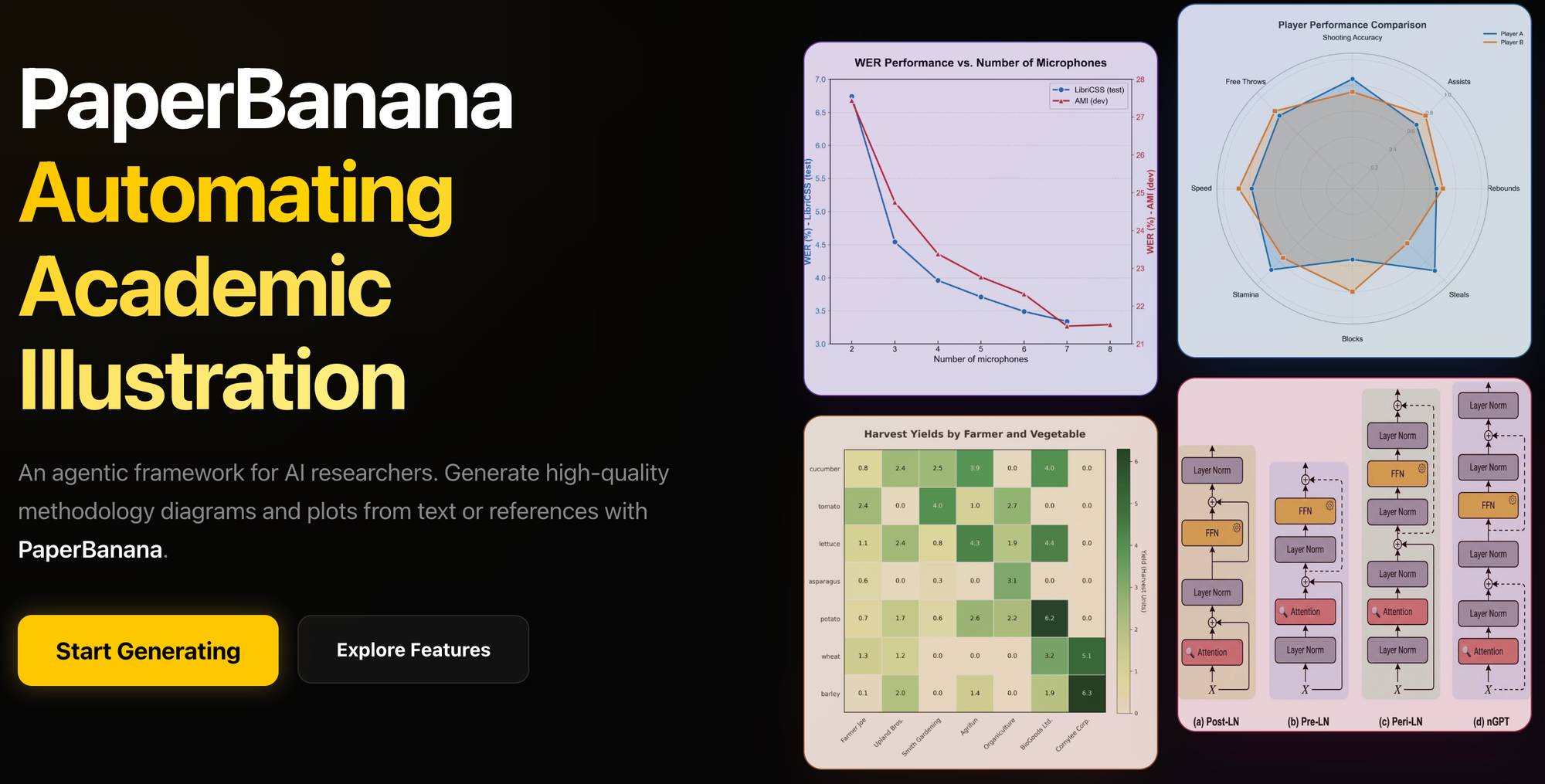

2. PaperBanana

구글과 베이징대 연구진이 발표한 PaperBanana는 학술용 도식과 그래프를 자동 생성하는 프레임워크입니다. 그동안 AI가 그린 그림은 "글자가 깨지거나 숫자가 틀리는 게 고질적인 문제였는데, 이걸 에이전트 협업 방식으로 해결했습니다. 정확한 데이터를 기반으로 코드를 짜서 그리는 방식이라 엄밀함이 살아있죠.

👉 인사이트

이제 보고서나 교육 자료의 퀄리티 기준을 다시 잡아야 합니다. 시각화 도구를 잘 다루는 스킬보다, "어떤 논리로 스토리를 짤 것인가"가 핵심 역량이 될 거예요. 대신 HR에서는 수치나 저작권에 대한 최종 검수 체크리스트를 실무 가이드로 제공해 줄 필요가 있습니다.

3. OpenClaw 이슈: "에이전트에게 어디까지 허용할 것인가"

현재 AI 분야에서 가장 현실적이고 뜨거웠던 이슈입니다. 국내 주요 AI 기업들이 오픈소스 에이전트인 OpenClaw 사용을 제한하기 시작했는데요. 실제로 네이버, 카카오 등 국내 대형 기업들에서 OpenClaw 사용을 공식적으로 금지했습니다. 이유는 심플하죠. 권한이 너무 강력해서입니다. 내 PC의 파일, 메일, 메신저까지 접근할 수 있다 보니 설정 실수 한 번에 정보 유출 사고가 터질 수 있거든요.

👉 인사이트

이제 사내 AI 정책을 단순히 채팅봇 금지 수준으로 만들면 안 됩니다. 에이전트는 권한을 가진 주체로 봐야 해요. 보안 팀과 협의해 고권한 도구에 대한 승인 프로세스를 만들고, 신규 입사자 교육에도 비밀번호 관리를 넘어 API 키/토큰 보안 같은 실전 항목을 꼭 넣어야 합니다.

AX의 시작은 기술이 아니라 ‘문제 정의’에서 출발합니다.

생성형 AI 활용부터 조직 전반의 AI 확산 전략까지, 귀사의 상황에 맞춘 최적의 솔루션을 함께 고민하겠습니다. AI·AX 전환과 관련한 교육, 컨설팅, 실행 방안이 필요하시다면 언제든 캐럿글로벌로 문의해 주세요!😊